算法在我们世界中无处不在,偏见也是如此。从社交媒体新闻推送、流媒体服务推荐到在线购物,计算机算法——特别是机器学习算法——已经渗透到我们日常生活的方方面面。至于偏见,我们只需要审视 2016 年的美国大选,就能理解偏见在我们社会中渗透的程度——无论是隐性的还是显性的。

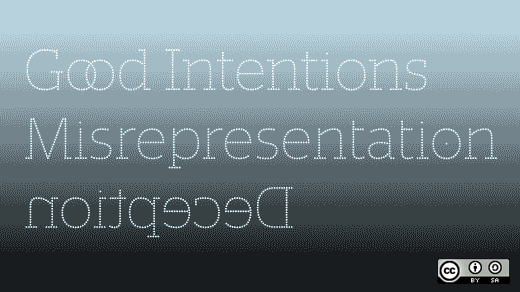

然而,经常被忽视的是这两者之间的交集:计算机算法本身的偏见。

与我们许多人可能认为的相反,技术并非客观。人工智能算法及其决策过程直接受到构建它们的人的影响——他们编写的代码、他们用来“训练”机器学习模型的数据,以及他们在完成后如何对模型进行压力测试。这意味着程序员的价值观、偏见和人类缺陷会反映在软件中。例如,如果我给图像识别算法输入我实验室中白人研究人员的面孔,它将无法识别非白人面孔为人脸。这样的结论并非“愚蠢”或“不成熟”的人工智能造成的,而是训练数据中的偏见造成的:缺乏多样化的面孔。这会带来危险的后果。

这样的例子不胜枚举。全国各地的州法院系统都在使用“黑匣子”算法来建议罪犯的刑期。这些算法对黑人存在偏见,因为训练它们的数据存在偏见——因此它们建议更长的刑期,从而使监狱中现有的种族差异永久化。所有这一切都发生在客观的、“科学的”决策制定的幌子下。

美国联邦政府使用机器学习算法来计算福利金和其他类型的补贴。但是关于这些算法的信息,例如它们的创建者和它们的训练数据,非常难以找到——这增加了公职人员在偏见下运作和系统性地分配不公平付款的风险。

这样的例子不胜枚举。从 Facebook 新闻算法到医疗保健系统再到警察随身摄像头,作为一个社会,我们正面临着将我们的偏见——种族主义、性别歧视、仇外心理、社会经济歧视、确认偏见等等——注入到将被大规模生产和大规模分发的机器中的巨大风险,而这些机器将在感知的技术客观性的掩盖下运作。

这种情况必须停止。

虽然我们绝不应该停止对人工智能的研究和开发,但我们需要放慢其发展速度,以便我们谨慎行事。算法偏见的危险已经太大了。

我们如何对抗算法偏见?

对抗算法偏见的最佳方法之一是审查输入到机器学习模型本身的训练数据。正如 微软的研究人员 指出的那样,这可以采取多种形式。

数据本身可能具有倾斜的分布——例如,程序员可能拥有更多关于美国出生的公民而不是移民的数据,以及关于富裕男性而不是贫困女性的数据。这种不平衡将导致人工智能对我们社会的实际代表性做出不恰当的结论——即,大多数美国人是富有的白人商人——仅仅是因为机器学习模型进行统计相关性的方式。

即使男性和女性在训练数据中得到平等代表,也可能出现这样的情况:这些代表本身会导致对人性的偏见理解。例如,如果所有“男性职业”的图片都是 CEO,而所有“女性职业”的图片都是秘书(即使实际上 CEO 中男性多于女性),人工智能可能会得出结论,女性天生不适合当 CEO。

我们可以想象类似的问题,例如,执法人工智能审查媒体中犯罪的表征,而数十项研究表明,这些表征极其倾向于黑人和拉丁裔公民。

训练数据中的偏见也可能采取许多其他形式——不幸的是,这里无法充分涵盖。尽管如此,训练数据只是一种审查形式;同样重要的是,在人工智能模型完成后对其进行“压力测试”,以找出偏见。

如果我们向摄像头展示一张印度面孔,它是否能被正确识别?即使求职者条件相同,我们的人工智能是否不太可能推荐来自市中心的求职者,而不是来自郊区的求职者?我们的恐怖主义算法如何应对关于白人国内恐怖分子和伊拉克恐怖分子的情报?我们的急诊室摄像头可以调出儿童的医疗记录吗?

这些显然是在数据本身中难以解决的问题,但我们可以通过全面的测试开始识别和解决这些问题。

为什么开源非常适合这项任务?

开源技术和开源方法都具有极大的潜力来帮助对抗算法偏见。

现代人工智能由开源软件主导,从 TensorFlow 到 IBM Watson,再到像 scikit-learn 这样的软件包。开源社区已经证明在开发健壮且经过严格测试的机器学习工具方面非常有效,因此,同一个社区也可以有效地将反偏见测试构建到同一个软件中。

例如,哥伦比亚大学和利哈伊大学的 DeepXplore 等调试工具使人工智能压力测试过程变得广泛,但也易于导航。这个项目和其他项目,例如 麻省理工学院计算机科学与人工智能实验室正在进行的工作,开发了开源社区应该采用的敏捷和快速原型设计。

开源技术也已被证明在审查和排序大型数据集方面非常有效。没有什么比开源工具在数据分析市场(Weka、Rapid Miner 等)中的主导地位更能说明这一点了。用于识别数据偏见的工具应由开源社区设计,这些技术也应应用于已发布在 Kaggle 等网站上的大量开放训练数据集。

开源方法本身也非常适合设计对抗偏见的流程。使关于软件的对话开放、民主化并与社会公益保持一致,对于解决部分由完全相反的情况——封闭的对话、私有软件开发和非民主化的决策制定——引起的问题至关重要。如果在线社区、公司和学术界在接近机器学习时可以采用这些开源特性,那么对抗算法偏见应该会变得更容易。

我们所有人如何参与进来?

教育至关重要。我们都认识一些可能没有意识到算法偏见,但关心其对法律、社会正义、公共政策等影响的人。与这些人交谈并解释偏见是如何形成的以及为什么重要至关重要,因为启动这些对话的唯一方法是自己启动它们。

对于我们这些以某种身份从事人工智能工作的人——作为开发人员、在政策方面、通过学术研究或以其他身份——这些对话甚至更加重要。那些正在设计未来人工智能的人需要了解偏见今天带来的极端危险;显然,将反偏见流程整合到软件设计中取决于这种意识。

最后,我们都应该围绕道德人工智能构建和加强开源社区。无论是为软件工具做出贡献、对机器学习模型进行压力测试,还是筛选千兆字节的训练数据,现在是我们利用开源方法的强大力量来对抗我们数字时代的最大威胁之一的时候了。

6 条评论