Carol Reiley 博士的成就数不胜数。她是自动驾驶汽车初创公司 Drive.ai 的联合创始人,该公司去年在第二轮融资中筹集了 5000 万美元。《福布斯》杂志将她评为“人工智能领域 20 位杰出女性”之一,并且她在约翰·霍普金斯大学攻读博士学位期间构建了智能机器人系统。

但是,当她构建语音激活的人机界面时,她自己的创造物却无法识别她的声音。

Reiley 博士使用微软的语音识别 API 构建了她的界面。但是,由于该 API 主要由年轻男性构建,因此尚未接触到足够多的声音变化。在多次尝试降低声音以便系统能够识别她之后,Reiley 博士聘请了一位男性毕业生来领导她的作品演示。

微软是否训练其 API 仅识别男性声音?可能不是。更有可能的是,用于训练此 API 的数据集没有包含足够广泛的具有不同口音、语调等的声音。

人工智能驱动的产品从它们训练的数据中学习。如果微软的 API 仅接触过特定年龄范围内的男性声音,它将不知道如何识别女性声音,即使是女性构建了该产品。

这是机器偏见的一个例子,而且它是一个比我们想象的更普遍的问题。

什么是机器偏见?

根据 Gartner 研究(客户可用),“当算法在进行预测和得出结论时,不公平地偏爱特定群体或不公正地歧视另一个群体时,就会出现机器偏见。”这种偏见有两种形式

- 直接偏见发生在模型基于敏感或违禁属性进行预测时。这些属性包括种族、宗教、性别和性取向。

- 间接偏见是不敏感属性的副产品,这些属性与敏感属性相关联。这是机器偏见更常见的形式。它也是更难检测到的偏见形式。

机器偏见对人类的影响

在我在 8 月份举行的北美开源峰会上的闪电演讲中,我分享了惩教罪犯管理替代制裁分析 (Correctional Offender Management Profiling for Alternative Sanctions, COMPAS) 算法,作为间接偏见的一个例子。美国 12 个以上的州的法官使用此算法来预测被告再次犯罪的可能性。

不幸的是,ProPublica 的研究发现,COMPAS 算法由于基于种族的间接偏见而做出了不正确的预测。该算法错误地将黑人被告列为再次犯罪的高风险人群的可能性是白人被告的两倍,而错误地将白人被告列为再次犯罪的低风险人群的可能性也是白人被告的两倍。

这是怎么发生的?COMPAS 算法的预测与种族(一种敏感/违禁属性)相关联。为了确认数据集中是否存在间接偏见,需要将一个群体的结果与另一个群体的结果进行比较。如果差异超过某个约定的阈值,则该模型被认为具有不可接受的偏见。

这不是一个“假设”情景:COMPAS 的结果影响了被告的刑期,包括刑期的长短以及被告是否获得假释。

部分基于 COMPAS 的建议,威斯康星州的一名法官拒绝了一名名叫 Eric Loomis 的男子的缓刑。相反,法官判处 Loomis 六年监禁,因为他驾驶了一辆曾用于最近枪击事件的汽车。

更糟糕的是,我们无法确认 COMPAS 如何得出结论:制造商拒绝透露其工作原理,这使其成为黑盒算法。但是,当 Loomis 将他的案件提交给最高法院时,大法官们拒绝受理。

这一选择表明,大多数最高法院大法官纵容该算法的使用,而不知道它是如何得出(通常是错误的)结论的。这开创了一个危险的法律先例,尤其是在人们对人工智能如何运作的困惑没有放缓迹象的情况下。

为什么您应该开源您的人工智能算法

开源社区在 8 月份举行的北美开源峰会的 Birds of a Feather (BoF) 会议期间讨论了这个问题。在这次讨论中,一些开发人员提出了保留机器学习算法私有的理由。

除了专有考虑因素外,这些黑盒算法还建立在无数神经元之上,每个神经元都有自己的偏见。由于这些算法从它们训练的数据中学习,因此它们有被不良行为者操纵的风险。一家大型科技公司的项目经理表示,他的团队 постоянно 警惕,以保护他们的工作免受那些心怀不轨的人的侵害。

尽管有这些原因,但强烈支持在可能的情况下公开用于训练机器学习算法的数据集。一系列开源工具正在帮助开发人员解决这个问题。

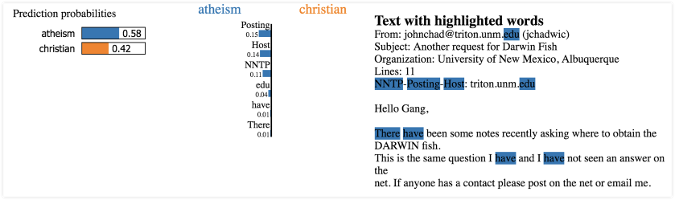

局部可解释模型无关解释 (Local Interpretable Model-Agnostic Explanations, LIME) 是华盛顿大学的开源 Python 工具包。它 не 试图剖析影响算法决策的每个因素。相反,它将每个模型都视为黑盒。

LIME 使用选择步骤来选择一组具有代表性的预测或结论进行解释。然后,它逼近最接近这些预测的模型。它操纵模型的输入,然后测量预测如何变化。

下图来自 LIME 的网站,显示了来自文本分类的分类器。该工具的研究人员选取了两个类别——无神论和基督教——这两个类别很难区分,因为它们共享如此多的词语。然后,他们训练了一个包含 500 棵树的森林,并获得了 92.4% 的测试准确率。如果准确率是您信任的核心衡量标准,那么您将能够信任此算法。

像 LIME 这样的项目证明,虽然机器偏见是不可避免的,但并非无法控制。如果您将偏见测试添加到您的产品开发生命周期中,您可以降低用于训练基于机器学习构建的人工智能驱动产品的数据集中的偏见风险。

避免算法厌恶

当我们不知道算法如何做出决策时,我们就无法完全信任它们。在不久的将来,公司将别无选择,只能更加透明地说明其创造物的工作原理。

我们已经看到欧洲的立法,如果大型科技公司不透露其算法的工作原理,将对其处以罚款。虽然这听起来可能有些极端,但这正是用户想要的。

芝加哥大学和宾夕法尼亚大学的研究表明,用户更信任可修改的算法,而不是专家构建的算法。当人们可以清楚地看到这些算法是如何工作时,即使这些算法是错误的,他们也更喜欢算法。

这支持了透明度在公众对技术的信任中所起的关键作用。它也为旨在解决此问题的开源项目提供了理由。

算法厌恶是真实存在的,而且理所当然。本月早些时候,亚马逊是最新一家机器偏见被曝光的科技巨头。如果这些公司无法为这些机器如何得出结论辩护,那么他们的最终用户将遭受损失。

我曾在 9 月份的 DC Startup Week 期间,在 Google Dev Fest DC 上就机器偏见(包括解决此问题的步骤)进行了完整演讲。10 月 23 日,我将在北卡罗来纳州罗利市的 All Things Open 上就同一主题发表演讲。

Lauren Maffeo 将在 10 月 21 日至 23 日于北卡罗来纳州罗利市举行的All Things Open上介绍从您的人工智能数据集中消除无意识偏见。

1 条评论